摘要

随着人工智能技术的快速发展,DeepSeek作为一款开源高性能的大语言模型,凭借其强大的推理能力和低资源消耗,成为行业焦点。然而,其线上服务的稳定性问题和高频访问限制,使得DeepSeek本地部署需求激增。本文将从环境准备、部署流程、性能优化到风险规避,全方位解析如何安全高效地实现DeepSeek本地部署,助你打造私有化AI助手。

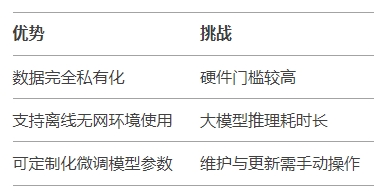

DeepSeek本地部署的核心优势在于数据隐私与自主控制。通过将模型运行在本地设备,用户无需依赖云端服务,避免了敏感信息泄露风险,同时可自定义模型参数以适应个性化需求。此外,本地部署还能在无网络环境下稳定使用,尤其适合企业内网或对响应速度要求高的场景。

- 最低配置:支持AVX2指令集的CPU、16GB内存、30GB存储(适合1.5B~7B参数模型)。

- 推荐配置:NVIDIA GPU(如RTX 3090)、32GB内存、50GB存储(支持14B~70B参数模型)。

- 依赖环境:Python 3.8+、Docker(可选)、Ollama或vLLM等工具。

DeepSeek提供多版本模型,需根据硬件性能选择:

- 入门级:1.5B/7B参数(消费级GPU适用);

- 高性能:32B/70B参数(需专业级GPU)。

1. 安装Ollama:从官网下载对应操作系统的安装包,验证安装成功后启动服务。

2. 拉取模型:执行命令`ollama run deepseek-r1:7b`自动下载并加载模型。

3. 交互界面集成:通过Open Web UI或Chatbox实现可视化操作,设置环境变量`OLLAMA_HOST=0.0.0.0`以启用本地访问。

1. 配置Python环境:安装Python 3.8+并验证版本。

2. 下载模型:通过ModelScope工具下载DeepSeek-R1模型至本地路径。

3. 启动vLLM服务:运行命令`vllm serve /path/to/model --port 8102`,调用API进行推理。

4. 性能调优:根据GPU显存调整`--max-model-len`参数,平衡速度与资源占用。

1. 安装客户端:从LM Studio官网下载并安装,选择非系统盘路径。

2. 加载模型:将DeepSeek-R1的GGUF格式模型文件存放至指定目录,通过界面一键加载。

3. 对话测试:内置聊天界面支持即时交互,无需命令行操作,适合小白用户。

1. 警惕山寨陷阱

- 仅通过DeepSeek官网或认证渠道下载资源,避免误入钓鱼网站支付“永久会员”等诈骗。

- 官方声明所有功能免费,任何收费项目均为非法。

2. 硬件适配建议

- 70B及以上大模型需专业级算力,普通用户推荐7B~14B版本。

- 若使用CPU推理,需预留充足内存并接受较长响应时间。

3. 法律风险提示

- 仿冒DeepSeek的软件可能涉及商标侵权与欺诈,消费者可依据《消费者权益保护法》索赔。

总结

DeepSeek本地部署为AI技术的深度应用提供了新可能,尤其在数据安全与自主控制领域表现突出。尽管存在硬件门槛和部署复杂度,但通过Ollama、vLLM等工具的支持,普通用户亦可逐步掌握部署技巧。未来,随着开源生态的完善,DeepSeek本地部署或将进一步简化,成为企业及个人AI应用的标配方案。

广告

广告